统计分析在质量管理中曾发挥了重大作用,特别是20世纪40年代,以休哈特的统计过程控制理论(Statistical Process Control, SPC)、道奇的质量抽样检测理论等为代表的统计质量控制,以及后续的多变量统计检验(如Hoteling-T2、Q-Statistics)等,将质量控制从定性的事后把关发展到定量的制造过程控制,将质量管理推入了科学管理的轨道。全面质量管理、社会质量管理等质量管理体系的发展,也在不断推进统计分析的发展,半导体等典型行业应用也为质量分析研究带来了很多有趣的问题。

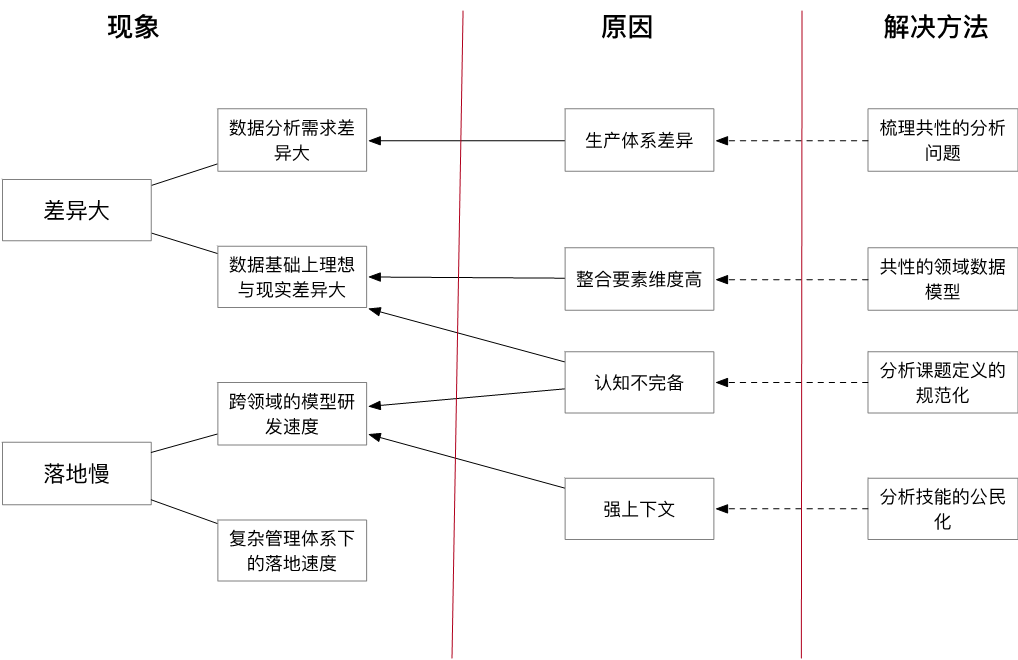

随着智能制造和物联网的发展,越来越多的过程数据、工艺数据、行为数据被采集,大数据应该有机会做出更多的事情。然而现实项目落地过程与期望存在较大偏差。笔者曾参与了电子、钢铁、化工、汽车等不同行业实践,有不少亲身体会;在图书、国家项目申请书、《质量大数据白皮书》撰写过程,有了更多形而上的思考。本文按照如下图所示的现象、原因、解决方法三个方面谈一下个人体会与粗浅认知,抛砖引玉,以期触发更深入的探讨。

质量大数据项目执行的现象:差异大、落地慢

差异大主要体现在2个方面,1)理想与现实的差异大,大家感觉中的数据、技术、管理基础与现实的差别大,数据分析结果与业务期望的差别。很多企业信息化和自动化实施很多年,每个领域单独看起来基础不错,但质量分析需要全流程、全要素、全周期的关联,数据基础的薄弱之处就凸显出来了。一个数据集的完整度是 90%,5 个数据集整合起来完整度 60% 都不到。2)不同行业间的分析需求差异很大、基础差异很大、落地措施差异很大,造成分析模型和应用的重用度低(只是个人咨询能力和算法技巧层面的积累),没有充分发挥“专业化分工的规模效益”。下表给出一些行业的典型质量分析课题,名字相同课题在不同行业的内涵与主要矛盾都不同。

表 1 一些典型行业的质量分析课题

| 行业 | 质量根因分析 | 控制参数优化 | 质量异常预警 | 质量时空模式分析 | 质量检测 |

|---|---|---|---|---|---|

| 面板 | ELA-Mura根因分析 | CIE控制参数优化、Mask PPA优化 | ELA-Mura不良的智能预警 | TFT智能排查、Particle追溯分析、Array路径差异分析 | 多层缺陷的智能识别 |

| SMT生产 | 钢网参数优化 | 刷锡质量预测 | 异常智能定位 | AOI不良品的智能复判 | |

| 新材料生产 | 质量波动的关联分析 | 关键设备的控制参数优化、能耗优化 | 异常模式挖掘 | 产品表面质量的图像研判 | |

| 化工 | 灌装质量分析 | 工艺参数优化、灌装控制优化 | 工艺参数波动的质量影响预测 | 漏封规律挖掘 | 煤质在线检测 |

| 医药 | 操作参数优化 | 批次规律分析 | |||

| 钢铁 | 波动性分析 | 黄金批次分析、在线调整 | 设备劣化趋势预警 | 米跟踪 | 表面质量图像检测 |

| 汽车制造 | 铸造缺陷根因分析 | 台车偏差自动识别、焊接参数异常预警 | 轮毂铸造成本估算、故障原因和处理措施的聚类 | 在线检测的自动校正 |

第二种现象就是落地慢,质量分析和落地通常需要跨工艺、自动化、信息化多个组织部门,经常还跨多个技术学科,1)这些跨领域协作信息损失量很大,效率效率不高;另外,2) 质量大数据分析结果需要与现有质量管理体系、组织流程或控制过程等融合才能落地,但这些融合方式的推进需要的精力可能远超预期。

背后的原因

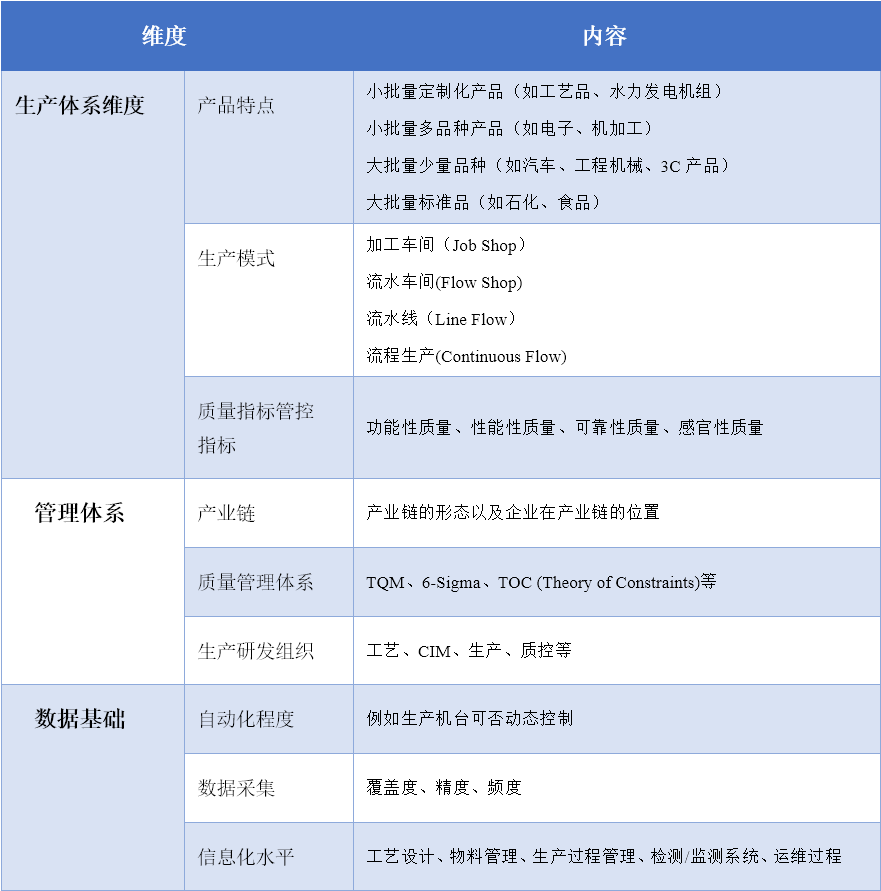

行业间差异大的根本原因是生产体系(包括产品类型、生产模式、关注的质量指标)的差异,从而造成管理体系和数据基础也存在较大差异,如下表所示。这些上下文决定了不同行业质量大数据的侧重点不同,例如,在医药、食品等行业,全产业链质量追溯是重点;对于半导体生产,先进制程控制(Advance Process Control, APC)是重点;对于装备制造,全生命周期(从研发、制造到运维)的质量管控与优化是重点。

落地慢的主要原因有三,1)质量大数据的数据整合工作通常严重拖慢分析项目进度。质量大数据分析是多种因素、多个过程共同作用的结果,需要整合不同数据源。即使没有数据质量问题,不同系统、数据协议、编码格式的多源数据集成通常就不容易。再加上“数据质量”问题、探索维度的多变性/灵活性,让数据供给工作变得很困难;2)认知不完备的问题。在质量大数据分析中,除了被规划到当前数据集中的要素外,通常存在大量未关联的要素、未被明确表达的隐性信息。这些问题领域专家看到“不合理”的分析结果才有可能意识到当前数据并不完备;3)在强领域上下文知识情形下,数据分析与领域知识这两种技能最好能够集中在一个人身上。但目前二者在组织界面上分割非常明确,领域专家掌握大量的隐性知识和信息,也具备改进措施的规划能力,但领域缺乏数据分析技能;而数据分析师通常没有这样的业务自由度,造成领域解读与数据分析需要大量的跨组织分工界面的交互协同,质量分析课题的节奏快不上去。第三方数据分析师每次都面临新的领域问题,分析效率也很难提升。

如果再深入一个层面,上面说的原因也只是现象,更深层次的原因工业大数据产业的资源配置机制的问题。新兴古典经济学将组织看做专业化(例如,分析技能积累效应)与交易成本(例如,分析协同中的信息损失)两难选择下的制度安排。这里面可以衍生出很多有意思的深层次话题,

- 第三方数据分析服务是否是一个合理的组织形态?若生产企业建立自己的数据分析师团队,这些分析师的技能成长如何保证?

- 高校从人才培养的角度应该侧重哪些方面?

- 不同组织(学界、大数据产品/服务商、生产企业)的有效的分工形式是什么?

本文先提出这些话题,后面有机会再专门讨论。

解决之道

解决差异性的方法主要方法是寻找共性,分而治之,也就是寻找共性的分析问题,将数据按照领域模型进行组织;解决认知不完备和强上下文的挑战,主要思路是规范化课题定义识别过程(通过流程规范认知,有所为有所不为),将基础分析技能推到领域专家。当然,还有其他方法。本节暂从这4个方面进行探讨。

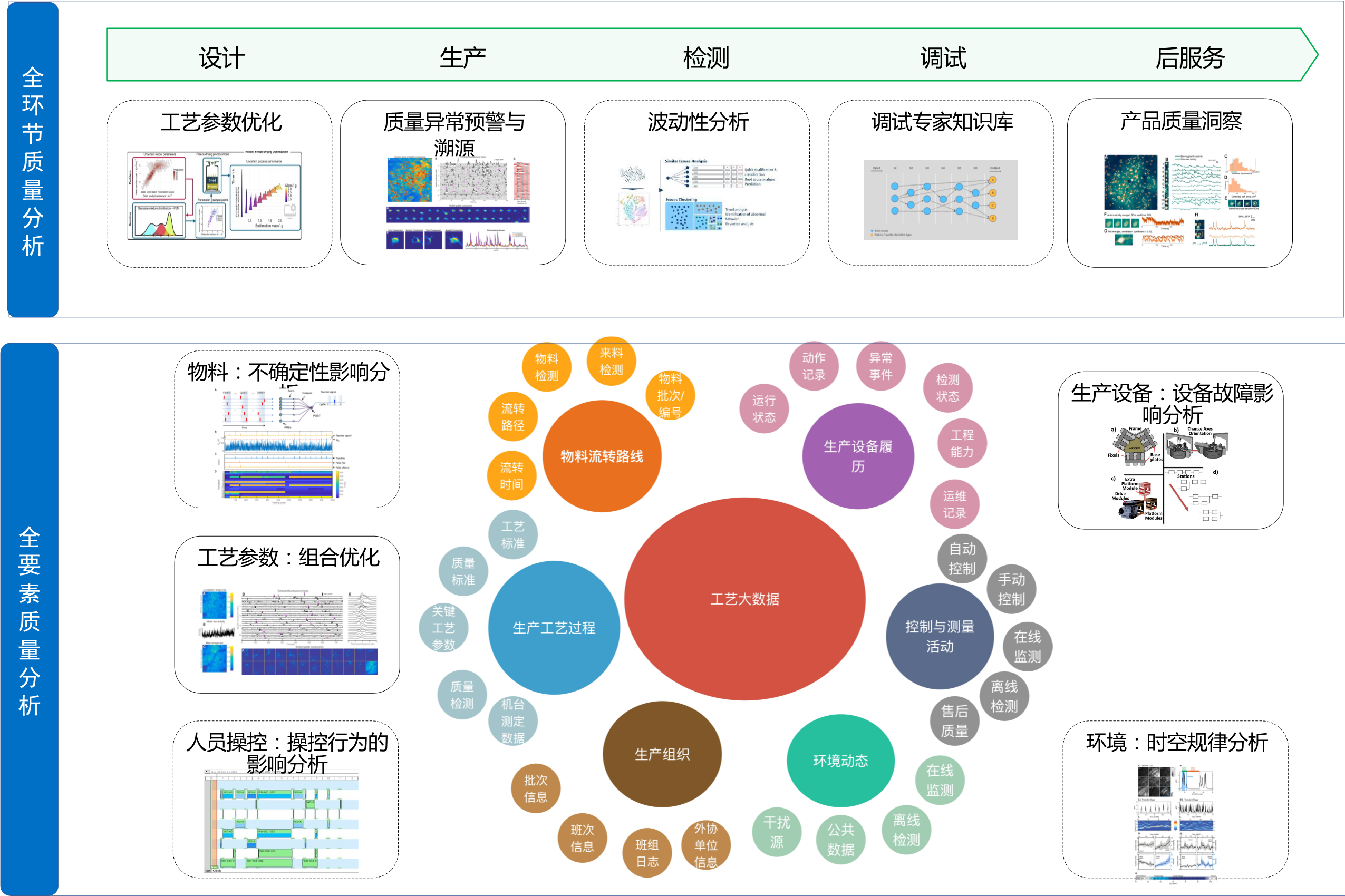

总结共性的分析问题

生产质量数据分析可以从如下图所示两个视角来看。1)从质量要素的视角,研究人、机、料、法、环等 5 个维度的共性分析需求和关键技术,研究物料不确定性、人工操控行为、设备运维、工艺参数和环境变化对质量的影响的分析模型。2)从生产活动的视角,探究工业大数据分析在设计、生产、检测、调试和后服务等环节中,如何实现质量管理的实时化、精细化、智能化、系统化和闭环化。

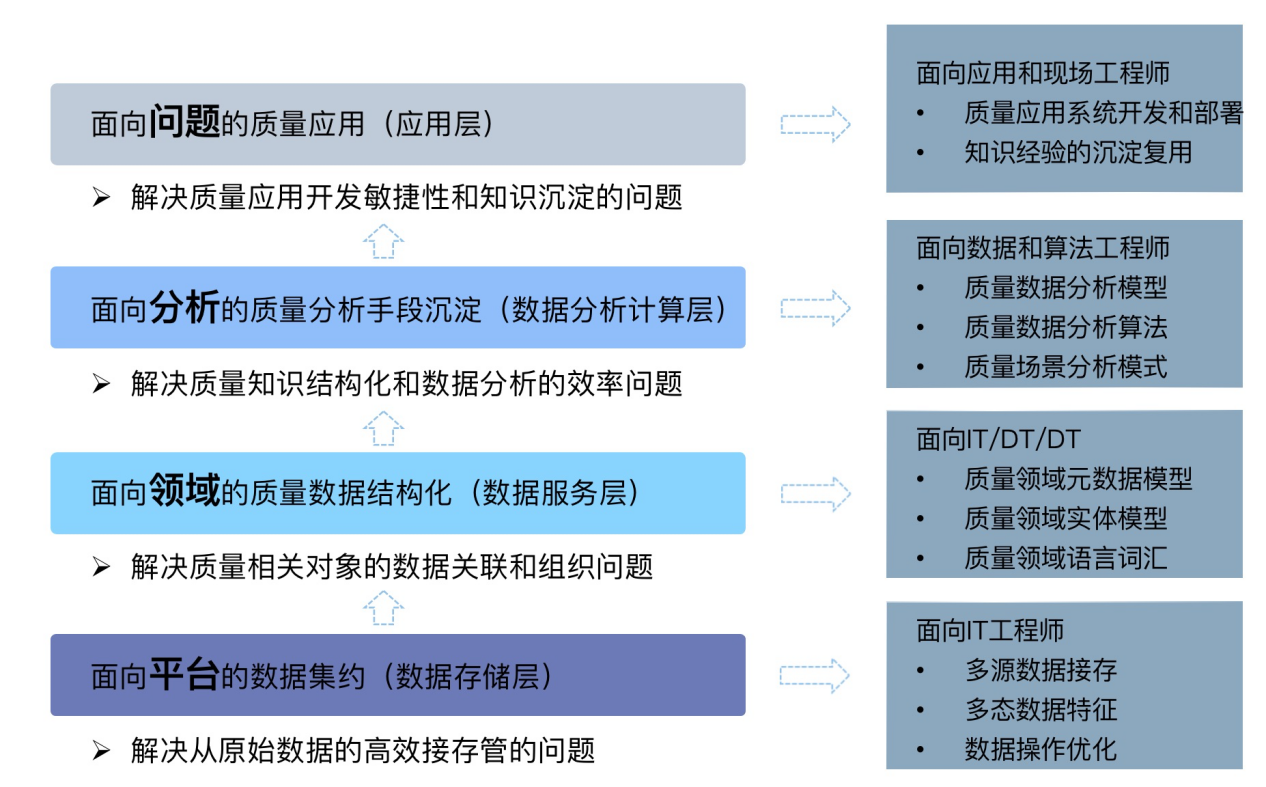

构建共性的领域数据服务

无论是上述哪种质量管控手段,质量相关的数据都是最重要的基础。为了让数据更好的被管理和消费,首先要建立质量数据平台,横向打通各线数据,对质量相关数据进行统一汇聚和集成。同时,数据平台需要端到端的考虑数据消费场景,同时支持数据管理、数据分析计算管理和质量分析应用。如下图所示。在数据模型上,有很多标准模型可以参考借鉴,如流程行业的 ISA-88,重点描述离散行业同时能兼容 ISA-88 模型的 ISA-99 生产信息整合模型,或者其他行业内的模型等等。

但需要说明的是,对于质量数据分析,数据供给不仅仅是 Data Schema 层面的领域模型,而是要有语义(Semantic)和语境(Context)的信息,其中的挑战在于不同分析课题在数据需求上的差异性以及存在大量隐性信息。

质量数据分析课题定义的规范化

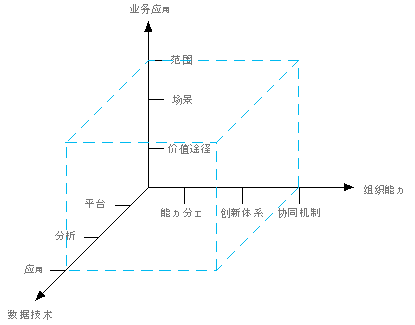

在质量分析课题上,大数据容易出现“冒进”的问题,即将质量问题简化为少量因素作用下的封闭问题:。以为有了一定量的数据,就可以实现工艺参数优化,殊不知需要考虑的维度远远高于 x。但是,只要对问题进行系统的梳理,结合一些专家经验和浅层次的机理知识,大数据就能解决很多繁杂、模糊、不精准的生产质量问题。任何一个分析课题在定义时,在分析上节表格中给出的 3 个上下文维度的基础要,从下图所示的业务应用、数据技术、组织能力等三个维度来确定质量分析课题的定位,具体定义方法在《工业大数据分析实践》第 5 章有所讨论,这里不再赘述。

分析技能的公民化

在很多工业质量应用领域,专业知识和背景信息的流动性和传递效率很差,远远低于分析技术能力的传递,根据组织经济学原理,最佳的组织形态应该是分析技能向质量领域移动,也就说,让质量领域专家掌握基础分析技能,同时通过软件平台工具适当降低使用门槛。大部分工业分析问题都遵循 8:2 原则,80% 的问题可用 20% 技术算法就可以解决,把其余 20% 的技术难题留给第三方技术服务商或学界。通常的做法是分层化,底层解决共性问题,但距离业务应用远,逐层缩小范围增加聚焦,在通用性和适用性间折中。

总结

本文讨论了质量大数据推进中出现的差异大、落地慢两类现象。不同行业差异大的本质原因还是生产体系的差异(生产力决定生产关系),落地慢的原因处理质量分析问题的数据维度高外,主要还是在于数据分析与领域专家的分工协同效率低。为此,在解决方法上,讨论了如何寻找分析问题、数据服务、课题定义方法上共性,以及如何将分析技能公民化的思路。这也引出了一些更深层次关于数据分析的社会分工与组织形态的深层次话题,欢迎大家一起讨论。

备注:“构建共性的数据服务”的第一段内容和图来源于北京工业大数据创新中心徐地博士。也感谢工业和信息化部电子第五研究所谢克强的讨论与启发。

发表/查看评论